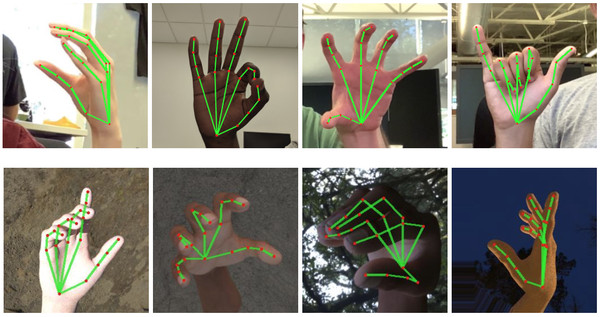

▲Google日前成功開發出一套演算法,從單幀中推斷出手部的21個3D關節點來提供高保真的手掌及手指追蹤。(圖/截自Google AI Blog)

記者王曉敏/綜合外電報導

拇指與食指指尖相貼,其餘三指自然伸展,對部分地區的人來說,可以很自然地從中解讀出「OK」之意。手勢解讀對人類來說可能是相當自然的一件事,但即時手部姿勢感知並解讀,對AI來說可就是一項極具挑戰性的電腦視覺任務了。Google日前成功開發出一套演算法,令智慧型手機能夠解讀手語。

Google在其AI部落格寫發表最新的手部感知方法,該方法透過機器學息,從單幀中推斷出手部的21個3D關節點來提供高保真的手掌及手指追蹤。目前Google尚未為此技術開發出應用程式,但已開放此技術的演算法,讓開發人員能加以利用並開發出自己的應用程式。目前為止,這類軟體僅能在PC上使用。

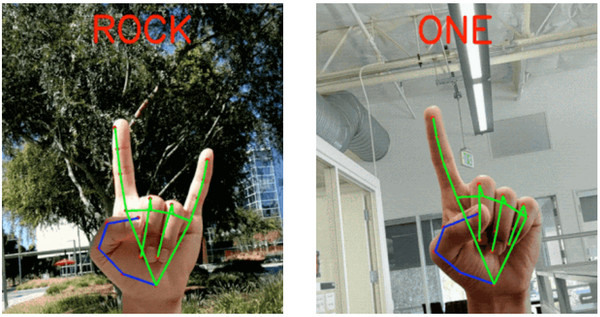

Google工程師巴扎列夫斯基(Valentin Bazarevsky)及張帆(Fan Zhang,音譯)在部落格中表示,這項免費公開的技術旨在成為「手語理解的基礎」。Google發言人說:「我們很期待開發人員會想出什麼樣的點子。就我們而言,我們將繼續展開我們的研究,使技術更加強大,進一步穩定對手語及手是的追蹤,增加我們可以可靠地偵測到的手勢數量。」

▲利用21個3D關節點,AI可即時解讀手勢所傳達的意義。(圖/截自Google AI Blog)

不過Google也坦言,這只是第一步。僅透過手勢產生語音內容的應用程式,可能會忽略比手勢者的面部語言及做手勢的速度,而這些都可能影響比手勢者所傳達的意思。除此之外,該技術也不會將任何地域性因素納入考慮。

聽力損失行動(Action on Hearing Loss)技術經理維西納勒姆(Jesal Vishnuram)表示,該計畫是「聽取」聽障人士語言的良好開端,但仍需要許多配套功能,「從聽障者角度來看,開發一種能將文本或語音翻譯成手語的軟體,以協助他們的日常對話、減少其在聽覺世界中的隔閡,會更加有用。」

以往類似的技術開發都會受限於影像追蹤技術。由於手指彎曲及手腕動作偶爾會遮蓋部分手部,因此無法準確地進行全面追蹤。為此,Google在手掌及手背上繪製了21個3D關節點,當手及手臂彎曲或兩根手指接觸時,電腦會更容易理解。

其他大型科技公司及研發人員也正試圖開發手語解讀技術。去年,微軟與美國國立聾人理工大學(National Technical Institute for the Deaf)合作,為教室配置桌電,透過即時翻譯員協助有聽力障礙的學生。另外,肯亞一名25歲的研發人員阿萊拉(Roy Allela)為其患有聽力障礙的姪女打造出一副觸覺手套,能利用Android應用程式,即時翻譯手語並朗讀,此發明也為阿萊拉奪下美國機械工程師協會的獎項。

|

|